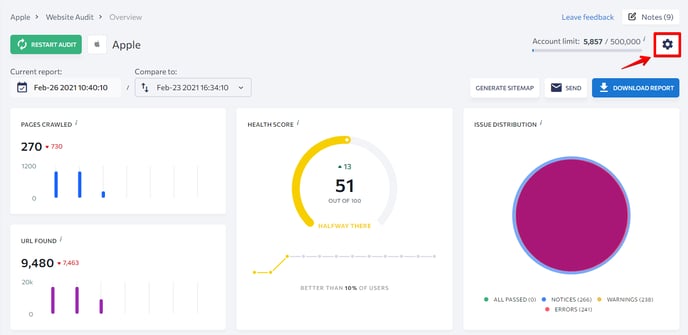

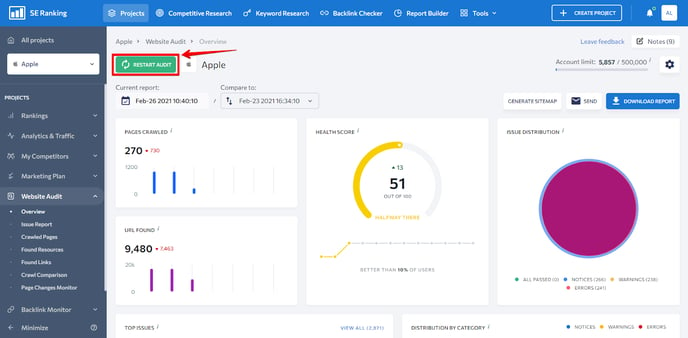

Mit Hilfe der flexiblen Einstellungen kannst du den gesamten Prozess sowie die Prüfungsergebnisse vollständig kontrollieren. Auf die Einstellungen kannst du von jedem Bereich des Tools aus zugreifen.

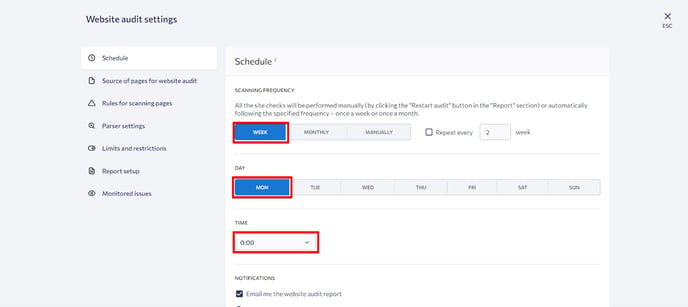

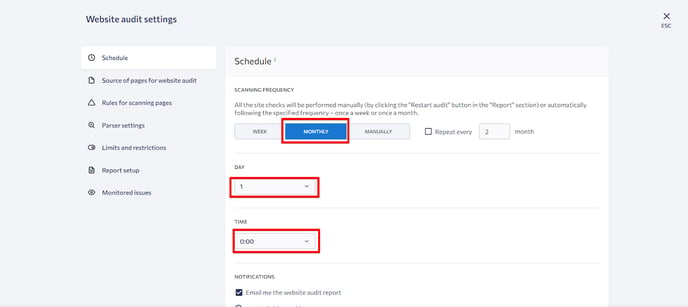

Zeitplan

Unter diesem Einstellungsblock kannst du entscheiden, wie oft du deine Website auditieren willst.

Die folgenden Optionen sind verfügbar:

1. Manuell.

Wenn du diese Option wählst, musst du manuell das Audit starten.

2. Wöchentlich.

Die Prüfung wird wöchentlich an einem Wochentag und zu einer Uhrzeit deiner Wahl durchgeführt.

3. Monatlich.

Die Prüfung wird monatlich an einem Wochentag und zu einer Uhrzeit deiner Wahl durchgeführt.

Die Zeit kann nur in der GMT-Zeitzone eingestellt werden.

Dennoch kannst du die Prüfung immer manuell starten, auch wenn du automatische Prüfungen eingerichtet hast.

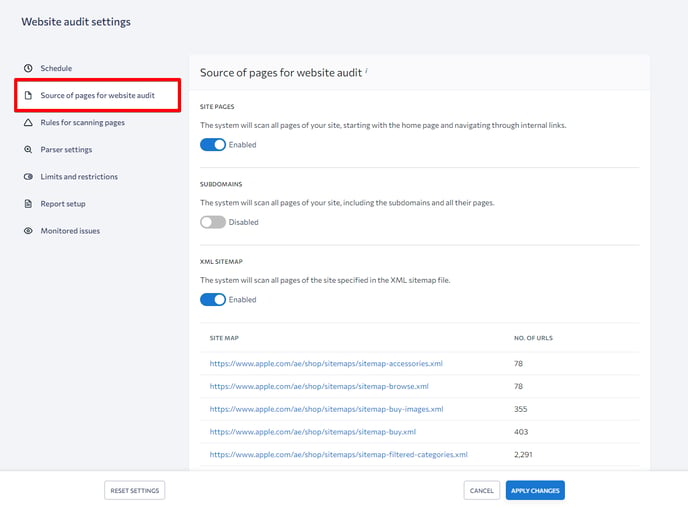

Quelle der Seiten für Website-Audit

Unter diesem Einstellungsblock kannst du dem Tool mitteilen, welche Seiten du prüfen willst.

- Seiten der Website.

Das Tool crawlt jede Seite der Website, beginnend mit der Startseite und folgt jedem internen Link, ohne Subdomains. - Subdomains.

Das Tool crawlt jede Seite der Website, einschließlich der Subdomains und ihrer Seiten. - XML-Sitemap.

Das Tool crawlt jede Seite, die in der XML-Sitemap angegeben ist.

Nach dem ersten Audit findet das Tool automatisch die XML-Sitemap, vorausgesetzt, sie befindet sich unter domain.com/sitemap.xml. Du kannst auch manuell einen Link zur XML-Sitemap hinzufügen, indem du auf die Schaltfläche Sitemap hinzufügen klickst. Sobald der Link hinzugefügt wurde, musst du deine Änderungen speichern. - Meine Liste der Seiten.

Du kannst deine eigene Liste der zu prüfenden Webseiten hinzufügen. Lade eine Datei im TXT- oder CSV-Format hoch. Jede URL-Adresse muss in eine neue Zeile geschrieben werden.

Bevor du mit der Prüfung deiner Website beginnst, kannst du angeben, welchen Pfad du überprüfen möchtest. Folgende Optionen stehen zur Verfügung:

- Bestimme ein oder mehrere Verzeichnisse für die Überprüfung (erlaubte Pfade).

- Ein oder mehrere Verzeichnisse angeben, die von der Überprüfung ausgeschlossen werden sollen (Pfade nicht zulassen).

- Gebe ein oder mehrere Verzeichnisse an, die nicht in den Bericht aufgenommen werden sollen.

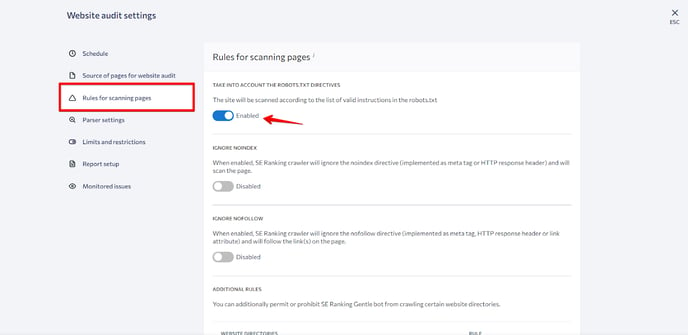

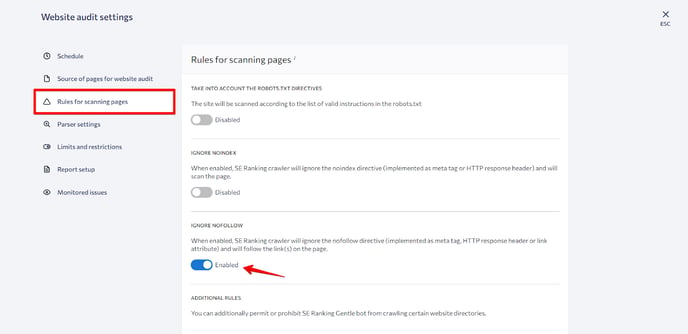

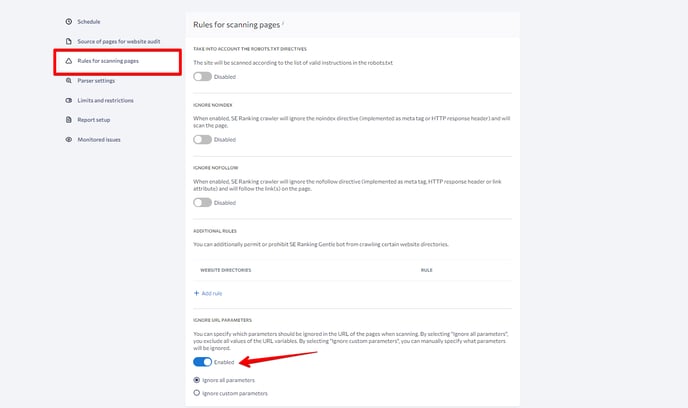

Regeln für das Scannen von Seiten

Unter diesem Einstellungsblock kannst du Regeln für das Crawlen von Seiten festlegen.

Zum Beispiel:

1. robots.txt-Richtlinien berücksichtigen.

Wenn diese Option aktiviert ist, crawlt das Tool die Website gemäß der Liste der gültigen Anweisungen in der robots.txt-Datei. Andernfalls ignoriert das Tool die Anweisungen der robots.txt-Datei.

2. Noindex ignorieren.

Wenn diese Option aktiviert ist, wird das Tool Seiten crawlen, die die Noindex-Direktive (in Form eines Meta-Tags oder eines HTTP-Response-Headers) ignorieren.

3. Nofollow ignorieren.

Wenn du diese Option aktivierst, weist du den SE-Ranking-Bot an, den Links auf der Seite zu folgen und dabei die Nofollow-Direktive (in Form eines Meta-Tags, eines HTTP-Antwort-Headers oder eines Link-Attributs) zu ignorieren.

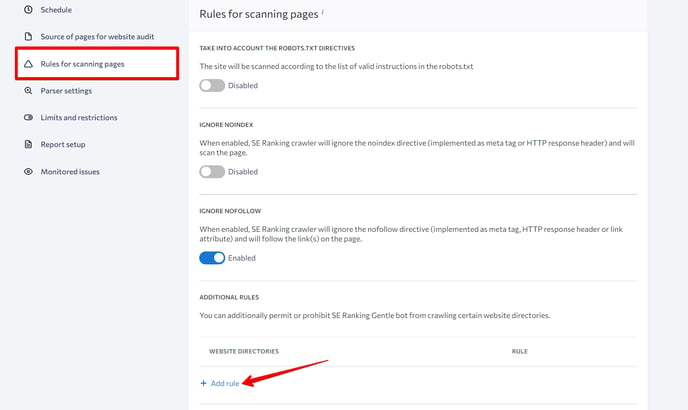

4. Zusätzliche Regeln. Mit dieser Option kannst du dem SE Ranking Bot zusätzlich erlauben oder verbieten, bestimmte Verzeichnisse der Website zu crawlen. Klicke dazu auf die Schaltfläche Regel hinzufügen.

4. Zusätzliche Regeln. Mit dieser Option kannst du dem SE Ranking Bot zusätzlich erlauben oder verbieten, bestimmte Verzeichnisse der Website zu crawlen. Klicke dazu auf die Schaltfläche Regel hinzufügen.

5. URL-Parameter ignorieren.

Hier kannst du festlegen, welche UTM-Tags in Seiten-URLs während des Audits ignoriert werden sollen. Du kannst entweder alle Parameter ausschließen oder die zu ignorierenden Parameter manuell auswählen.

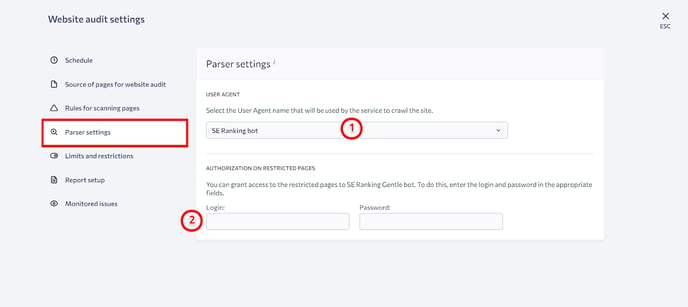

Parser-Einstellungen

Das Tool ermöglicht es dir, einen Bot auszuwählen, der das Crawling durchführt, und bietet Zugang zu Seiten, die für Suchroboter gesperrt sind.

1. Wähle einen User Agent.

Standardmäßig ist der SE Ranking Bot ausgewählt. Wenn die analysierte Website nicht von unserem Bot erreicht werden kann, kannst du eine andere Option aus der Liste auswählen. Unabhängig davon, welcher User Agent ausgewählt ist, werden alle Seiten deiner Website gecrawlt (auch wenn du Googlebot-Image auswählst).

2. Autorisierung auf gesperrten Seiten.

Du kannst gesperrte Seiten crawlen. Dazu gibst du unserem Bot Zugang, indem du deine Anmeldedaten in den entsprechenden Feldern angibst.

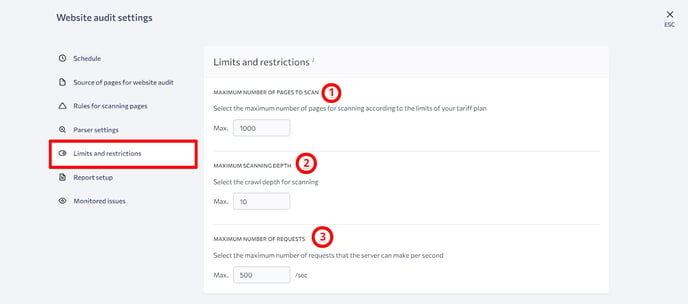

Limits und Einschränkungen

In diesem Bereich kannst du Crawling-Limits und Einschränkungen konfigurieren. Du kannst für jede Website unter deinem Account eigene Grenzen und Einschränkungen festlegen.

Hier sind die verfügbaren Einstellungen:

- Die maximale Anzahl der zu scannenden Seiten.

Wähle die Anzahl der Seiten entsprechend deines Abonnements. - Maximale Scantiefe.

Wähle die Crawl-Tiefe. - Maximale Anzahl von Anfragen.

Je nach den Fähigkeiten des Servers kannst du die Anzahl der Anfragen pro Sekunde erhöhen, um die Berichterstellung zu beschleunigen. Du kannst sie aber auch verringern, um die Serverlast zu reduzieren. Standardmäßig ist die optimale Anzahl auf 5 Abfragen pro Sekunde eingestellt.

Einrichtung des Berichts

Bei der Analyse der Website-Parameter orientiert sich SE Ranking an den aktuellen Empfehlungen der Suchmaschinen. Im Bereich Einrichtung des Berichts kannst du die Parameter ändern, die das Tool beim Crawlen von Websites und bei der Erstellung von Berichten berücksichtigt.

Darüber hinaus haben wir eine neue Funktion eingeführt, mit der du Gastlinks für die auf der SE Ranking-Plattform erstellten Audit-Berichte erstellen kannst. Dank dieser teilbaren Berichte ist es jetzt viel einfacher, den Fachleuten, mit denen du zusammenarbeitest, Informationen zu präsentieren. Diese Funktion ist sowohl im Standalone-Tool als auch bei projektbasierten Audits verfügbar.